Das klassische on-premise Data Warehouses und seine Probleme

Viele Unternehmen nutzen Data Warehouses (DWH) zum zentralen Speichern von Geschäftsdaten an einem Ort. Dieser Datenspeicher dient als Grundlage komplexer Analysen im Kontext von Business Intelligence (BI) und Analytics. In einem DWH werden Daten aus verschiedenen heterogenen Datenquellen extrahiert, harmonisiert und abgelegt, damit diese für Analysen und zur Auswertung genutzt werden können, wodurch Managemententscheidungen unterstützt werden. Der Aufbau und Betrieb eines klassischen on-premise DWH ist mit hohen Vorab-Investitionskosten verbunden. Dies liegt zum einen an dem Vorhalten von großen Speicherkapazitäten, welche benötigt werden um große Datenmengen zu speichern und zum anderen an hohen Rechenkapazitäten, welche komplexe Anfragen fordern, um diese in adäquater Zeit effizient durchzuführen. Auch der fortlaufende Betrieb eines on-premise DWH ist aufgrund von Ressourcenmanagement, Monitoring und Performance Optimierung etc. kosten- und personalintensiv.

BigQuery als cloud-basierte Alternative zum on-premise Data Warehouse

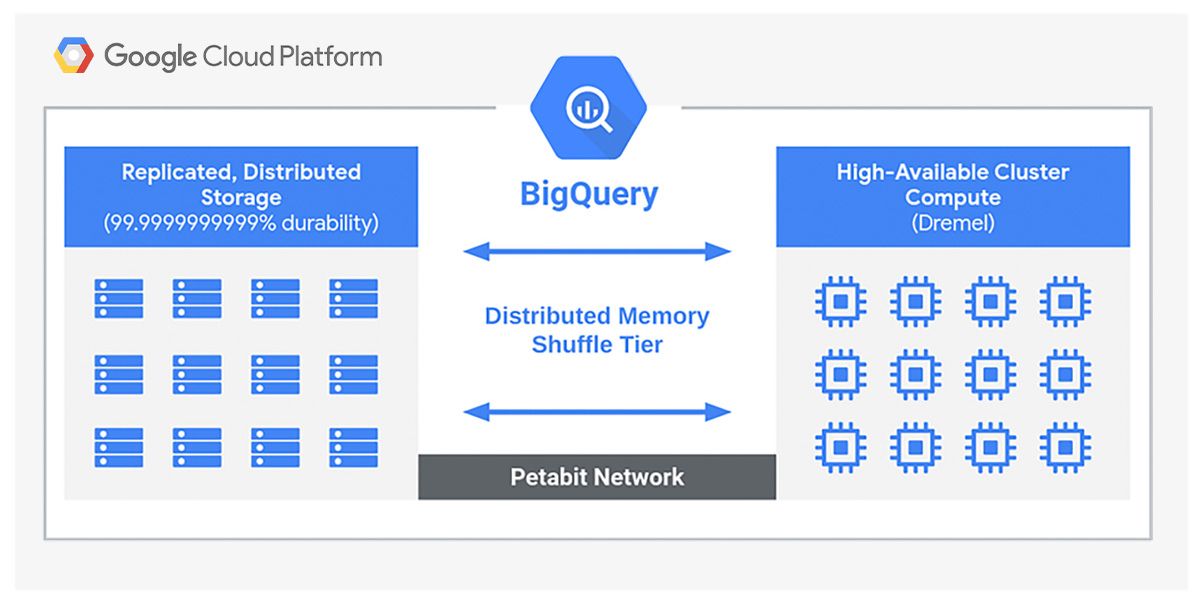

Eine Alternative zu einem teuren on-premise DWH ist Google BigQuery. Hierbei handelt es sich um ein cloud-basiertes Enterprise Data Warehouse für Advanced Analytics in der Google Cloud Plattform. BigQuery bietet die Möglichkeit Daten im Exabyte-Bereich zu speichern und SQL-Abfragen im Petabyte-Bereich durchzuführen. Abfragen in Datensätzen mit mehreren Millionen Zeilen können ad hoc gestartet werden und sind in wenigen Sekunden abgeschlossen.

Der Kerngedanke beim Umzug oder Aufbau eines DWH in der Cloud ist die Trennung von Storage und Datenverarbeitung (Compute). Durch diese Trennung lassen sich beide Teile eines DWH den Anforderungen entsprechend skalieren und können effizient und kostengünstig betrieben werden. Diese flexible Skalierung erfolgt entsprechend der Datenmenge und Zugriffszahlen automatisch ohne vorhergehende Allokation von Hardwareressourcen. Das ist möglich, da BigQuery vollständig serverlos aufgebaut ist und auf alle verfügbaren Ressourcen der Google Cloud Plattform zurückgreifen kann. Somit können auch unerwartete Spitzen im Workload abgefangen werden, wodurch die Performance nicht beeinträchtigt wird. Aus diesem Grund verzichtet BigQuery auf die übliche Überdimensionierung eines DWH. Durch die serverlose Architektur, erfordert BigQuery allgemein keine Planung und Dimensionierung der DWH-Konfiguration, um benötigte Leistungsanforderungen zu erfüllen. Die erforderlichen Speicher- und Rechenkapazitäten werden entsprechend der Datenmenge automatisch in Anspruch genommen.

Kostenvorteile Dank BigQuery

Im Gegensatz zu anderen Cloud DWH-Lösungen erfordert BigQuery keine Verträge mit Mindestlaufzeiten und Vorauszahlungen. Hier wird auf das Pay-as-you-go-Prinzip gesetzt. Wie auch bei den anderen Diensten der GCP gilt: Es muss nur das bezahlt werden, was auch tatsächlich genutzt wird. Für Unternehmen, welche große Datenmengen speichern und analysieren, gibt es flatrate pricing (Staffelpreise), welches die Kosten weiter senkt. In Summe können mit BigQuery bis zu 52% der “total cost of ownership” gegenüber eines on-premise DWH eingespart werden. Darüber hinaus besteht die Option Daten, welche älter als 90 Tage sind, automatisch in einen kostengünstigen Speicher zu verschieben, um automatisch Kosten reduzieren. Beide Möglichkeit des Kostenmanagements bieten maximale Flexibilität und Anpassung für den jeweiligen Kunden.

Wie bereits erwähnt, liegt einer der größten Vorteile von BigQuery darin, dass keine Vorabinvestitionen in teure DWH-Infrastruktur notwendig sind. Das macht BigQuery für kleinere und mittelständische Unternehmen interessant, bei denen eine Investition in Hardware nicht lohnenswert oder möglich ist. BigQuery bietet hier die optimale Möglichkeit strategische Entscheidungen etc. mit Hilfe von Data Analytics zu verbessern.

Datensicherheit und Hochverfügbarkeit

BigQuery bietet wie alle Storage-Dienste der GCP eine hervorragende Ausfallsicherheit und Hochverfügbarkeit. Durch Replikation von Daten in mehrere Regionen sind diese bei Ausfall eines Rechenzentrums vor Verlust geschützt. Gleichzeitig bietet die Replikation über mehrere Regionen in einem solchen Fall die Möglichkeit, dass weiterhin Abfragen ausgeführt werden können und somit die eigenen Geschäftsprozesse nicht eingeschränkt werden.

Die Speicherung aller Daten erfolgt per Voreinstellung verschlüsselt und erfüllt alle rechtlichen Anforderungen an Datenschutz und Privacy. Hierzu zählt auch die freie Wählbarkeit der geografischen Region, in welcher die Daten von BigQuery gespeichert werden. Zusätzlich sind die Daten durch Googles eigene Sicherheitstechnologien vor Angriffen und unautorisiertem Schreiben/Lesen geschützt. Diese Technologien werden stetig weiterentwickelt, um auch neueste Gefahren sicher abwehren zu können.

Durch BigQuery für die Zukunft gewappnet

Mit BigQuery können Unternehmen in Echtzeit Einblicke in Geschäftsdaten bekommen und Erkenntnisse aus riesigen Datenmengen generieren ohne die oben beschriebenen Vorab-Hardware oder Software-Investitionen. Die Analysemöglichkeiten reichen von ad-hoc Analysen der momentanen Nachfrage bis hin zu Dashboards zur fortlaufenden Überwachung des Geschäftsgeschehens, beispielsweise mit der BI Platform Looker. Solche Abfragen können einfach über die Webbrowser-basierte UI oder das REST Interface erfolgen und z.B. als Spreadsheet exportiert werden.

Des Weiteren ist BigQuery die einzige Cloud-DWH-Lösung, welche nativen Support für künstliche Intelligenz und Machine Learning bereitstellt. Beide Verfahren werden im Feld von Data Analytics immer wichtiger. Die Anwendung beider Technologien trägt dazu bei mehr Informationen für Managemententscheidungen zu generieren und somit mögliche Wachstumspotenziale zu identifizieren und vollständig auszuschöpfen. BigQuery legt den Grundstein, um von beiden Technologien bestmöglich zu profitieren.