In diesem Blogbeitrag werde ich Amazon Elastic File System (EFS) in Verbindung mit AWS Backup besprechen. Es ist durchaus möglich, dass Sie bei der Verwendung von EFS und AWS Backup versehentlich doppelte Backups erstellen, was zu doppelten AWS Backup-Kosten führt. In diesem Artikel erkläre ich, warum dies geschieht, und schlage eine Lösung vor, um dies mithilfe einer benutzerdefinierten AWS Config-Regel zu überwachen.

Was sind EFS und AWS Backup?

Amazon Elastic File System (EFS) ist ein Managed-File-System-Service, der skalierbaren, elastischen Speicher für die Verwendung mit AWS-Diensten und lokalen Ressourcen bietet. Er ermöglicht mehreren Instanzen den gleichzeitigen Zugriff auf Daten und ist damit ideal für Anwendungsfälle wie Big Data und Analysen, Datenverarbeitungsworkflows und Content Management.

AWS Backup ist ein Full-Managed-Service, der die Datensicherung über AWS-Services hinweg zentralisiert und automatisiert. Er vereinfacht den Prozess der Datensicherung und -wiederherstellung und sorgt für Geschäftskontinuität und die Einhaltung gesetzlicher Vorschriften.

Die „Falle“ der doppelten Backup-Kosten

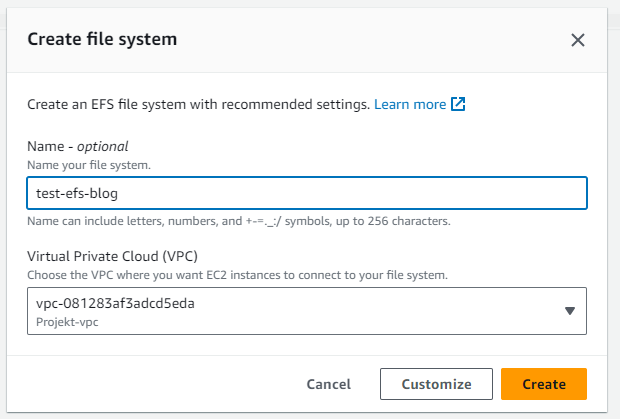

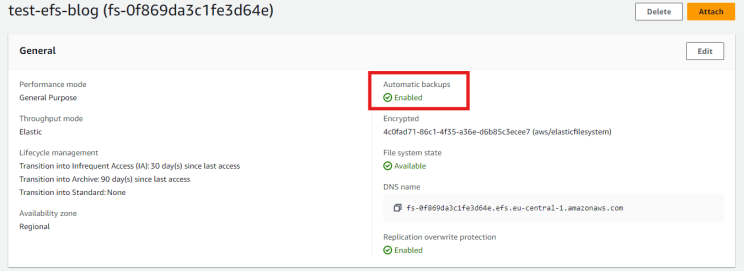

Wenn ein neues Amazon Elastic File System (EFS) erstellt wird, ist die Funktion „Automatische Backups“ des EFS standardmäßig aktiviert. Dies führt zur Erstellung eines AWS-Sicherungsplans mit dem Namen „aws/efs/automatic-backup-plan“ und eines Sicherungsdepots mit dem Namen „aws/efs/automatic-backup-vault“, in dem die Backups automatisch mit einer Gesamtaufbewahrungszeit von 5 Wochen gespeichert werden.

Erstellungsassistent zum Erstellen eines EFS-Dateisystems

Automatische Backups sind standardmäßig aktiviert

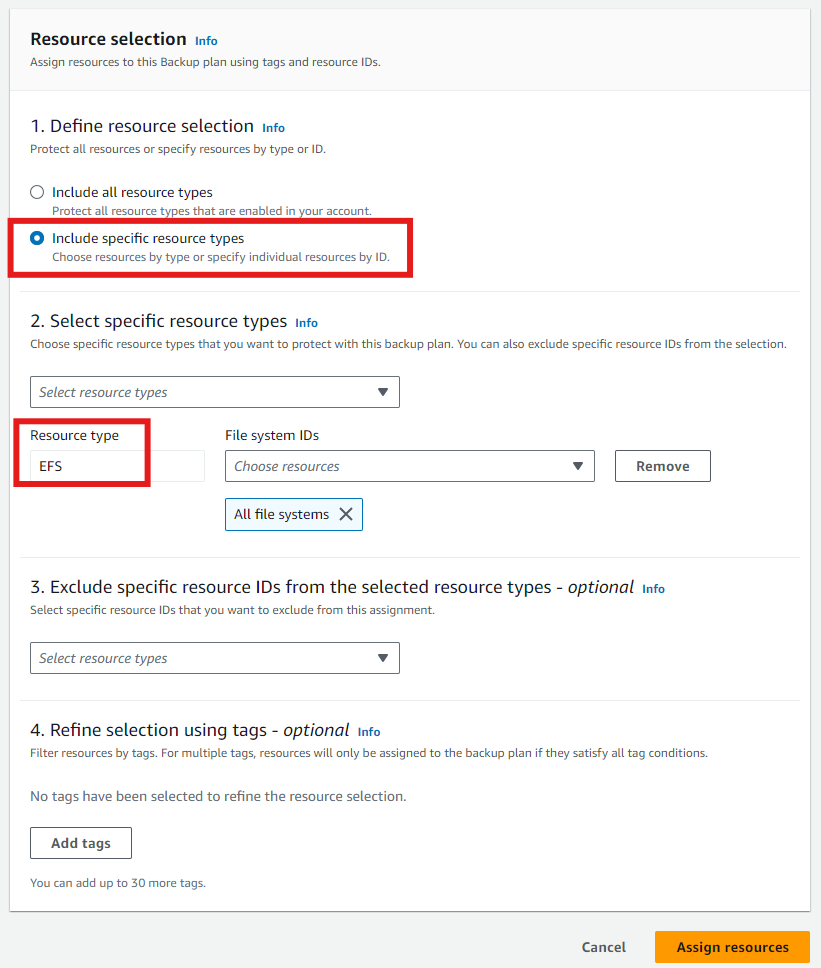

Wenn jedoch AWS Backup Pläne auch auf alle Konten in der AWS-Organisation ausgeweitet werden oder wenn der Kontonutzer zusätzliche AWS Backup Pläne einrichtet, die das EFS entweder nach Ressourcentyp oder über Tags einschließen, wird das EFS-Dateisystem in verschiedenen Backup Vaults gesichert. Diese Redundanz führt zu doppelten AWS Backup Kosten.

Einen AWS Backup Plan erstellen

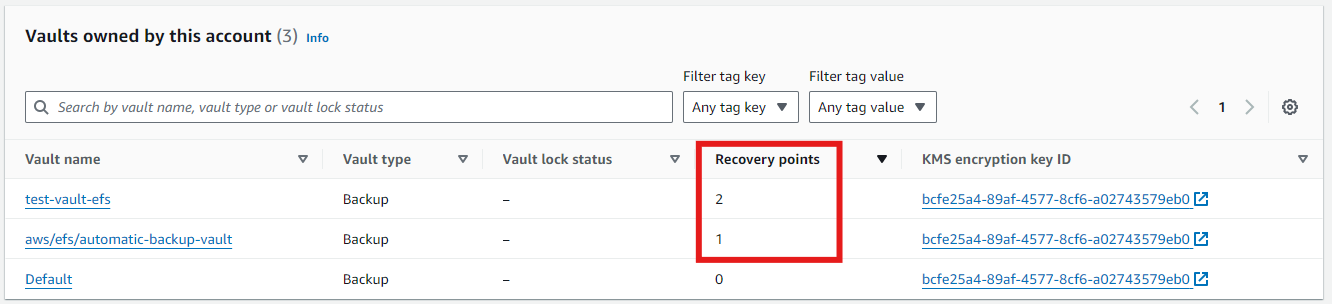

In diesem Beispiel habe ich zwei EFS-Dateisysteme erstellt: eines mit aktivierten „automatischen Sicherungen“ und eines ohne. Außerdem werden alle EFS-Dateisysteme mit einem benutzerdefinierten AWS Backup Plan gesichert. Infolgedessen wurden über Nacht zwei Sicherungen im Backup Vault „test-vault-efs“ und eine im „Automatic Backup“-Vault „aws/efs/automatic-backup-vault“ gespeichert.

AWS Backup Vault Ansicht

Wie können wir auf doppelte Backups für EFS-Dateisysteme achten?

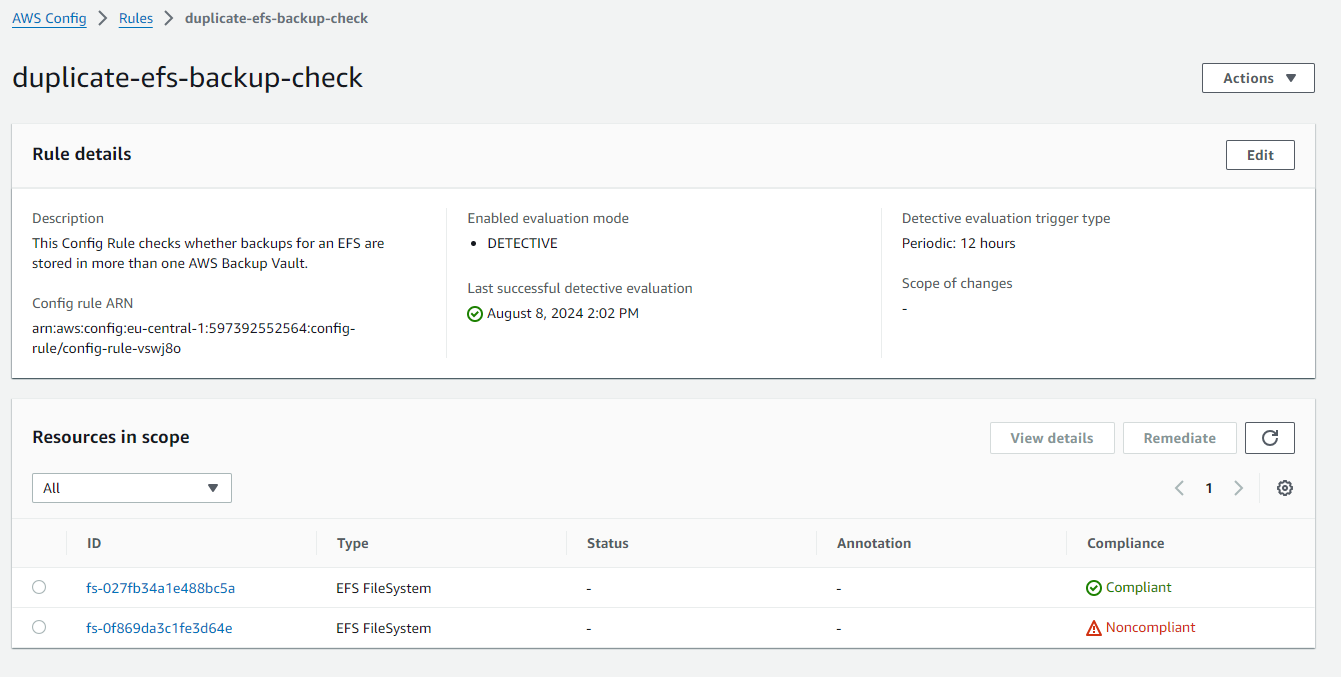

Um zu überwachen, ob doppelte Backups für EFS-Dateisysteme erstellt werden, habe ich eine benutzerdefinierte AWS Config-Regel erstellt. Diese Regel prüft alle 12 Stunden, ob EFS-Dateisysteme Wiederherstellungspunkte in mehr als einem Backup Vault haben. Ist dies der Fall, wird das EFS als nicht konform gekennzeichnet.

Hier ist ein Beispiel mit meinen zwei Test-EFS-Dateisystemen, von denen eines konform und das andere nicht konform ist.

AWS Config Custom Regel

Wenn EFS-Dateisysteme mit doppelten Backups gefunden werden (d. h. als nicht konform gekennzeichnet sind), können Sie die automatische EFS-Sicherung für diese Systeme einfach deaktivieren.

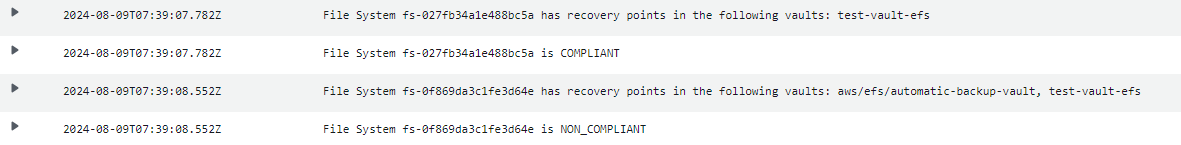

Darüber hinaus generiert die zugehörige AWS Lambda-Funktion ein Protokoll, das genau zeigt, welche EFS-Dateisysteme über Sicherungen in welchen Backup-Vaults verfügen.

Lambda-Log-Gruppen

Nachfolgend finden Sie die CloudFormation-Vorlage, die die Lambda-Funktion für die Prüfung, die entsprechende IAM-Rolle sowie die AWS-Konfigurationsregel, die alle 12 Stunden ausgeführt wird, erstellt.

Dieser Stack kann entweder direkt in Ihrem AWS-Konto oder in der gesamten AWS-Organisation über CloudFormation StackSet oder Lösungen wie CfCT oder LZA

bereitgestellt werden. Wenn der AWS Config Aggregator in Ihrer Umgebung eingerichtet ist, haben Sie auch die Möglichkeit, in der gesamten AWS-Organisation nach doppelten Backups von EFS-Dateisystemen zu suchen.

Warum nicht eine SCP verwenden?

Es könnte eine Frage aufkommen: Wenn AWS Backup Pläne in der gesamten AWS-Organisation automatisiert werden, um alle EFS-Dateisysteme zu sichern, warum wird dann nicht einfach eine SCP (Service Control Policy) verwendet, um automatische EFS-Sicherungen zu deaktivieren? Zum jetzigen Zeitpunkt (August 2024) ist es leider nicht möglich, eine SCP zu erstellen, die verhindert, dass automatische EFS-Sicherungen aktiviert werden.

Wenn Ihre AWS-Organisation zentral verwaltete AWS-Backup-Pläne zur Sicherung aller EFS-Dateisysteme verwendet, können Sie meine AWS Config Custom Rule in Verbindung mit einer AWS Config Remediation Aktion verwenden, um automatische EFS-Sicherungen zu deaktivieren.

Abschließende Worte

Ich hoffe, mein Artikel hat Ihnen gefallen und Sie finden meine benutzerdefinierte AWS-Konfigurationsregel nützlich für die Überwachung doppelter EFS-Sicherungen in Ihrer Umgebung. Die potenziellen Kosteneinsparungen können beträchtlich sein. Ich konnte mit diesem Ansatz bei einem Kunden bis zu 12.000 US-Dollar pro Monat einsparen! Sollten Sie weitere Unterstützung bei der AWS-Kostenoptimierung benötigen, steht Ihnen unser Team bei PCG jederzeit gerne zur Verfügung.

Entdecken Sie auch unseren Service AWS Cost Management and Optimisation!