Zwischen dem Hype und dem „Wie geht das eigentlich?“ klafft oft eine Lücke. Sie haben gehört, was Generative AI leisten kann – Inhalte erstellen, Kundenerlebnisse transformieren, Workflows automatisieren. Aber das in eine konkrete Lösung für Ihr Unternehmen zu übersetzen? Das ist eine andere Geschichte.

Viele der Menschen, mit denen wir sprechen – Geschäftsführende, Innovationsverantwortliche, digitale Teams – wissen, dass Generative AI enormes Potenzial hat. Aber sie fragen sich:

- „Wo sollen wir überhaupt anfangen?“

- „Wie nutzen wir unsere eigenen Daten, ohne alles von Grund auf neu zu bauen?“

- „Was, wenn es ein Vermögen kostet oder wir die falschen Tools wählen?“

Dieser Artikel soll helfen, genau diese Unsicherheit zu überwinden. Egal, ob Sie erste Experimente machen oder schon eine konkrete Idee im Kopf haben: Wir zeigen Schritt für Schritt, wie Sie mit Generative AI („GenAI“) auf AWS bauen können. Und wir zeigen anhand realer Beispiele mit Diensten wie Amazon Bedrock, OpenSearch

und AWS Lambda

, wie andere es bereits erfolgreich gemacht haben – damit Sie nicht das Rad neu erfinden müssen.

Schritt 1: Verstehen, was Sie bauen können – und womit

Bevor Sie sich in Code oder Architekturdiagramme stürzen, ist es wichtig, die grundlegenden Möglichkeiten zu verstehen. GenAI ist kein einzelnes Tool oder magischer Knopf – es ist ein Set von Fähigkeiten, die Sie je nach Use Case in leistungsstarken Kombinationen einsetzen können.

AWS stellt eine breite Palette an Bausteinen für GenAI-Lösungen bereit. Hier sind die wichtigsten Services, die Sie kennen sollten:

- Amazon Bedrock

API-basierter Zugriff auf führende Foundation Models von Anthropic (Claude), Meta (Llama 2), Mistral und Amazon Titan. Vollständig verwaltet – kein eigenes Hosting nötig. - Amazon Nova

Der neue GenAI-Assistent von AWS unterstützt Sie beim Schreiben, Debuggen und Abfragen – in natürlicher Sprache und über verschiedene AWS-Services hinweg. Nova ist Entwicklungsbeschleuniger und nutzerzentriertes Support-Tool in einem. - Amazon S3

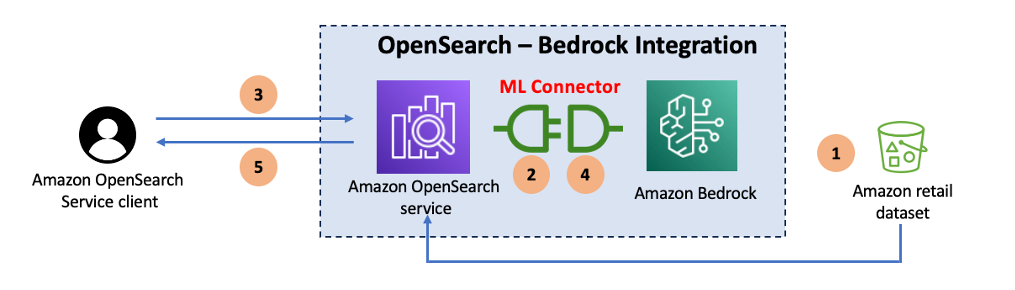

Skalierbarer Speicher für Dokumente, PDFs, Produktdaten oder beliebige Dateien, auf die Ihre GenAI-Lösung zugreifen oder aus denen sie Informationen extrahieren soll. - Amazon OpenSearch Service

Ermöglicht vektorbasierte Ähnlichkeitssuche – entscheidend beim Aufbau intelligenter Abrufsysteme wie Chatbots oder semantischer Suchfunktionen. - AWS Lambda

Serverlose Funktionen zum Auslösen von Workflows, Synchronisieren von Daten oder Transformieren von Ein- und Ausgaben zwischen verschiedenen Services. - Amazon Comprehend / AWS Rekognition / Amazon Transcribe

Vorkonfigurierte ML-Services für Aufgaben wie Sentimentanalyse, Entitätenerkennung, Bild- und Videoklassifikation oder Speech-to-Text. Minimaler Setup-Aufwand, kein eigenes Modelltraining erforderlich. - Amazon SageMaker

Umfassende Suite für Training, Deployment und Feinjustierung eigener Machine-Learning-Modelle – ideal, wenn Sie volle Kontrolle benötigen oder hochspezialisierte Anforderungen haben.

Wenn Sie diese Services verstehen, können Sie gezielt das richtige Tool für die jeweilige Aufgabe wählen. Die meisten erfolgreichen Projekte starten klein – vielleicht nur mit Bedrock und Lambda – und entwickeln sich von dort aus weiter. Sobald Sie wissen, was Ihr Werkzeugkasten enthält, können Sie echte Probleme lösen.

Schritt 2: Wählen Sie einen realen Anwendungsfall

Ohne ein klares Ziel in GenAI einzusteigen, ist wie eine Autofahrt ohne Karte zu beginnen. Der beste Startpunkt ist, ein konkretes Problem zu identifizieren, das gelöst werden soll. Das könnte zum Beispiel die Generierung von Inhalten, die Verbesserung der Suche, die Zusammenfassung von Dokumenten oder die Gewinnung von Erkenntnissen aus unstrukturierten Daten sein.

Werfen wir einen Blick auf zwei sehr unterschiedliche, aber reale Beispiele:

Agrovia: Von Felddaten zu kundentauglichen Inhalten

Agrovia, ein schwedisches Startup, unterstützt kleine Lebensmittelproduzenten beim Vermarkten ihrer Produkte. Viele dieser Kunden hatten weder Zeit noch Ressourcen, um hochwertige Inhalte zu erstellen. Mithilfe von AWS entwickelte Agrovia eine Lösung, die:

- Eine maßgeschneiderte Pipeline mit AWS Lambda und Step Functions verwendete, um strukturierte Daten aus Tabellenkalkulationen und Webquellen zu verarbeiten

- In Amazon Bedrock integrierte, um natürlichsprachliche Produktbeschreibungen zu generieren

- Marketingtexte in Sekundenschnelle lieferte, wodurch der manuelle Aufwand erheblich reduziert wurde

Das Ergebnis: Kleine Produzenten konnten schneller ansprechende Inhalte veröffentlichen – und damit Kunden schneller erreichen, ohne technisches Know-how oder kreative Unterstützung im eigenen Team zu benötigen.

KI transformiert das Marketing für Kleinproduzenten

Griechisches Nationales Dokumentationszentrum (EKT)

Das Nationale Dokumentationszentrum Griechenlands (EKT) verfügte über eine riesige Sammlung wissenschaftlicher Inhalte, die über herkömmliche Schlüsselwortsuche nur schwer zugänglich war. Gesucht wurde ein mehrsprachiges, intelligentes Sucherlebnis für Forschende. In Zusammenarbeit mit uns entstand eine Lösung, die:

- Dokumente in Amazon S3 speicherte

- Sie mit OpenSearch und semantischen Vektor-Embeddings indexierte

- Amazon Bedrock (Claude + Titan) nutzte, um kontextbezogene Antworten zu generieren

- Ergebnisse mit Quellenangaben lieferte und so wissenschaftliches Vertrauen unterstützte

Das Resultat war eine hochskalierbare, forschungsfreundliche Plattform, die griechische wissenschaftliche Inhalte auf internationaler Ebene besser zugänglich machte – ohne wissenschaftliche Strenge oder Datenintegrität zu gefährden.

An diesem Punkt ist es an der Zeit, Dinge in die Praxis umzusetzen. Idealerweise haben Sie bereits einen Anwendungsfall im Kopf – aber keine Sorge, falls nicht. Der nächste Schritt besteht darin, etwas auszuprobieren und durch eine kleine, einfache Anwendung herauszufinden, was möglich ist.

Unlocking Scientific Knowledge: EKT’s AWS-Based AI Retrieval System

Schritt 3: Bauen Sie eine einfache GenAI-Anwendung (wirklich)

Sobald Sie einen Anwendungsfall identifiziert haben, ist es Zeit, wirklich etwas zu bauen. Es muss noch keine vollständige Anwendung sein – ein funktionaler Proof of Concept [Link: Proof of Concept for AI: Why It’s the Best First Step] ist eine hervorragende Möglichkeit, die Machbarkeit zu testen und internes Buy-in zu gewinnen.

Beispielsweise könnten Sie ein leichtgewichtiges Tool entwickeln, das:

- Einen Prompt von einem Benutzer entgegennimmt (z. B. „Fasse dieses Meetingprotokoll zusammen“)

- AWS Lambda verwendet, um die Anfrage an Amazon Bedrock weiterzuleiten

- Eine Antwort von einem Foundation Model wie Claude 3.7 empfängt

- Diese über eine einfache Oberfläche anzeigt (z. B. Slack-Bot, interne Web-App, CLI)

Diese Art von leichtgewichtigem Prototyp ist ein idealer erster Schritt, weil sie echten Nutzen schnell demonstriert – bei gleichzeitig geringer technischer Komplexität und im Rahmen dessen, was auch Einsteiger gut umsetzen können:

- Nutzer bekommen ein Gefühl dafür, was GenAI leisten kann

- Prompts lassen sich schnell weiterentwickeln

- Die zentralen Services werden eingeführt, ohne tiefgreifende Infrastruktur

Wenn Sie das Ganze in einem kontrollierten Umfeld live gesehen haben, sind Sie gut aufgestellt für die nächste Entscheidung: Möchten Sie eigene Daten integrieren, Automatisierung hinzufügen oder für Skalierung designen?

Schritt 4: Integrieren Sie Ihre Daten mit Retrieval-Augmented Generation (RAG)

Sobald Sie bewiesen haben, dass Ihre GenAI-Anwendung nützliche Antworten generieren kann, besteht der nächste Schritt darin, diese Antworten durch die Integration Ihrer eigenen Daten relevanter und zuverlässiger zu machen. Hier kommt Retrieval-Augmented Generation (RAG) ins Spiel.

RAG kombiniert semantische Suche mit Sprachmodellen. Anstatt zu versuchen, ein Modell auf Ihren Daten zu fine-tunen, gehen Sie folgendermaßen vor:

- Speichern Sie Ihre Daten in einem System wie Amazon S3

- Erstellen Sie Vektor-Embeddings mit einem Modell (z. B. Amazon Titan)

- Indexieren und rufen Sie relevante Dokumente mit OpenSearch ab

- Geben Sie die abgerufenen Textausschnitte in Ihren GenAI-Prompt ein, um eine genauere, kontextbezogene Antwort zu erhalten

Genau das hat EKT getan, um seine Herausforderungen bei Suche und Zugänglichkeit zu überwinden. Ihre Plattform wurde von Grund auf so konzipiert, dass große Mengen wissenschaftlicher Inhalte für Forschende besser auffindbar und nutzbar sind – unter Nutzung des vollständigen Spektrums an GenAI- und Suchfunktionen von AWS:

- Über 25.000 Dokumente wurden verarbeitet

- Embeddings für semantisches Indexieren wurden generiert

- Mehrsprachige Abfragen in Echtzeit ermöglicht

- Antworten mit Quellenangaben zurückgegeben, um Vertrauen in die Resultate zu stärken

Indem Sie die Antworten des Modells auf Ihrer eigenen Wissensbasis aufbauen, schaffen Sie etwas weitaus Nützlicheres als generische KI-Antworten – und vermeiden zugleich die Notwendigkeit, ein Modell komplett neu zu trainieren. Nachdem Ihre GenAI-Anwendung jetzt auf Ihren eigenen Daten basiert, ist der nächste Schritt sicherzustellen, dass sie reibungslos, sicher und zuverlässig läuft.

Schritt 5: Absichern, Überwachen, Automatisieren

Mit zunehmender Reife Ihrer Lösung müssen Sie Aspekte wie Sicherheit, Überwachung und Automatisierung berücksichtigen. Die gute Nachricht? Diese gehören zu den nativen Stärken der AWS-Plattform.

Darauf sollten Sie den Fokus legen:

- IAM – Beschränken Sie den Zugriff auf Bedrock-APIs und Datenquellen

- CloudWatch – Überwachen Sie Protokolle, Latenzen und Fehler von Bedrock und Lambda

- Automatisierung mit Lambda – Halten Sie Ihr System aktuell – wie z. B. bei EKT mit dem automatischen Tagging und der Synchronisierung neuer wissenschaftlicher Dokumente

Wenn Sie Sicherheit und betriebliche Transparenz von Anfang an mitdenken, vermeiden Sie technische Schulden und spätere Probleme. Mit diesem Fundament können Sie nun beginnen, weitere Intelligenzebenen hinzuzufügen.

Schritt 6: NLP oder tiefere Analyse hinzufügen (optional)

Nachdem Ihre Kerninfrastruktur etabliert und zuverlässig läuft, können Sie den Fokus nun auf die Erweiterung der Intelligenz Ihrer Anwendung richten, indem Sie verbessern, wie sie Ihre Daten interpretiert. Viele Aufgaben – wie Zusammenfassungen, Schlüsselwortextraktion oder Sentimentanalyse – lassen sich mittlerweile direkt durch Prompt Engineering mit Modellen wie Claude über Amazon Bedrock umsetzen. Dieser Ansatz bietet oft mehr Flexibilität und reduziert den Bedarf an zusätzlichen Services.

Wenn Ihr Projekt jedoch auf planbare Kosten, schnelle Verarbeitung strukturierter Aufgaben oder Plug-and-Play-Funktionen angewiesen ist, könnten Dienste wie Amazon Comprehend weiterhin eine Überlegung wert sein. Der beste Weg hängt von Ihrer Arbeitslast und Ihrem Budgetprofil ab.

Im Fall von Agrovia entwickelte das Team eine schlanke Datenverarbeitungsschicht mit AWS Lambda und Step Functions, um relevante Produktinformationen aus Tabellen und Onlinequellen zu extrahieren. Diese strukturierten Daten wurden anschließend an Bedrock übergeben, wodurch hochwertige, konsistente Marketinginhalte generiert wurden, die die individuellen Angebote der Produzenten widerspiegelten.

Egal, ob Sie integrierte NLP-Services oder ein leistungsstarkes Foundationmodel mit sorgfältig gestalteten Prompts verwenden – das Grundprinzip bleibt gleich: Wenn Sie Ihre Eingaben durchdacht vorbereiten, werden Ihre Ausgaben intelligenter, konsistenter und besser auf Ihre Marke abgestimmt sein.

Schritt 7: Kosten und Skalierung optimieren

Selbst die intelligenteste Lösung muss betrieblich sinnvoll sein. GenAI kann ressourcenintensiv sein, doch AWS bietet Möglichkeiten, um alles schlank und reaktionsschnell zu halten. Hier sind einige praktische Strategien, mit denen Sie Leistung und Kosten in Einklang bringen können:

- Verwenden Sie provisioned throughput, wenn Ihre produktive GenAI-Anwendung den regulären Durchsatz übersteigt – Überbeanspruchung kann teuer werden

- Richten Sie Modell-Aliase ein, um Prompt-Workflows sicher weiterzuentwickeln

- Setzen Sie auf serverlose Tools wie Lambda und verwaltete Dienste wie Bedrock, um Infrastrukturaufwand zu vermeiden

- Speichern Sie Daten effizient in S3, und lassen Sie OpenSearch das Indexieren skalieren, wenn Ihr Datensatz wächst

Das System von EKT zeigt, wie das in der Praxis funktioniert: Ein cloud-natives, serverloses Design ermöglichte es ihnen, die Inhaltsabdeckung und Sprachunterstützung zu erweitern – bei gleichzeitig überschaubaren Betriebskosten. Sobald Ihre App stabil, skalierbar und sicher ist, sind Sie bereit, über das Proof of Concept hinauszugehen.

Abschluss: Vom ersten Schritt zur vollständigen Lösung

Sie haben die Werkzeuge zur Hand – und die Erfolgsgeschichten, die zeigen, dass sie funktionieren. Die Gelegenheit, etwas wirklich Wirkungsvolles zu schaffen – für Ihr Team, Ihre Kunden oder Ihre gesamte Organisation – ist zum Greifen nah.

Mit den GenAI-Services von AWS und einer klar definierten geschäftlichen Herausforderung können Sie Ideen schneller als gedacht in funktionierende Lösungen umsetzen. Beginnen Sie klein mit einem Proof of Concept. Sobald Sie bereit sind, integrieren Sie Ihre eigenen Daten. Skalieren Sie dann sicher, überwachen Sie die Leistung und lassen Sie Ihre Anwendung sich mit Ihren Anforderungen weiterentwickeln.

Ob Sie nun Produktinhalte erstellen wie Agrovia oder intelligente Forschung ermöglichen wie EKT (oder was auch immer Ihnen vorschwebt) – GenAI auf AWS macht es möglich, schnell voranzukommen und klug zu bauen.

Lassen Sie uns gemeinsam etwas aufbauen

Wenn Sie bereit sind, den nächsten Schritt zu gehen – oder einfach nur herausfinden möchten, was GenAI für Ihre Organisation bedeuten könnte – wir sind für Sie da. Wir haben Unternehmen in ganz Europa dabei unterstützt, ihre GenAI-Ideen in produktionsreife Lösungen zu verwandeln: pünktlich, im Budget und skalierbar. Melden Sie sich bei uns, um herauszufinden, wie Ihr erster Schritt aussehen könnte.